[OpenStack Class] 제51강 Glance에 Ubuntu 이미지 올리기

[OpenStack Class] 제51강 Glance에 Ubuntu 이미지 올리기

안녕하세요~!!정말 거의 한달만에 글을 올리는 것 같습니다.요즘 좀 많이 바뻐서 글을 올릴 시간이 없었습니다. 그래서, 오늘도 역시 새벽에 이렇게 글을 올려봅니다.그동안 오픈스택이 무엇인지 그리고, 어떻게 설치하면 되는지에 대해 포스팅을 했었습니다. 오늘부터는 사용방법에 대해 포스팅을 할까합니다. 이미 다 아신다구요? 책에 있는 모든 내용은 다 공개해 드리기로 약속했으니, 아는 내용이라도 다 올려드릴려고 노력하고 있습니다. 자 그럼 지금부터 Glance에 우분투 이미지를 한번 올려봅시다. Glance에 우분투 이미지 올리기클라우드 운영체제 이미지 중 가장 많이 사용하는 운영체제는 바로 우분투입니다. 이번에는 Glance를 이용해서 우분투 이미지를 등록해 보겠습니다. 우분투 클라우드 이미지 다운로드오픈스택..

드디어 6장까지 모두 올렸습니다. 요즘은 JUNO가 릴리즈되어서 대부분 JUNO 설치 테스트를 주로 하지만, 아직도 현장에서는 CentOS6.5를 많이 사용하고 있기 때문에 IceHouse 버전이 아직까지는 많이 설치되고 있습니다. 그럼, 다음 포스팅에서부터는 7장 오픈스택 운영하기 편을 올려드리도록 하겠습니다. Nova Compute 설치패키지 설치가 완료되고 시스템을 재부팅하면 Nova Compute를 설치해야 합니다. 1. 먼저 openstack-nova-compute를 설치합니다. # yum install openstack-nova-compute 2. Openstack-config를 이용해서 /etc./nova/nova.conf에 데이터베이스 정보와 Keystone 정보를 설정합니다. # open..

바로 이어서 컴퓨트 노드편 올려드립니다. 오늘 6장까지 모두 올려야 겠어요~!! ^^ 컴퓨트 노드를 설치해 보자 Nova-network는 Neutron 네트워킹과 다르게 네트워크 노드가 필요하지 않습니다. 그래서 컨트롤러 노드와 컴퓨트 노드 여러 대로 구성합니다. 컴퓨트 노드는 기본 하이퍼바이저 KVM(또는 Qemu)과 Nova 컴퓨트를 설치합니다. 네트워크 인터페이스 설정 컨트롤러 노드와 마찬가지로 CentOS를 설치한 후에 네트워킹 IP를 설정해야 합니다. /etc/sys config/network-scripts 디렉터리에 들어가 각각의 이더넷 카드에 해당하는 환경설정 파일로 IP를 설정해 보겠습니다. 1. 컨트롤러 노드와 마찬가지로 /etc/sysconfig/network-scripts/ifcfg-..

안녕하세요~!! 이것저것 벌려놓은게 많아서 이일저일 하느라 정작 블로그에 글을 올릴 시간은 별로 없네요~!! 오늘 시간을 내서 글 한번 올려봅니다. 오늘 공개하는건 Horizon 설치와 Cinder 설치 부분입니다. 다음 포스팅에서는 컴퓨트 노드 설치편을 올리도록 하겠습니다. Horizon 설치이번에는 오픈스택을 쉽게 사용할 수 있게 제공되는 데쉬보드 서비스인 Horizon을 설치해 보겠습니다. 1. 먼저 mamcached, python-memcached, mod_wsgi, openstack-dashboard를 설치합니다. # yum install memcached python-memcached mod_wsgi openstack-dashboard 2. /etc/openstack-dashboard/loca..

바로 이어서 다음편 올려봅니다. 지금 안올리면 올릴 시간이 없어서예요~!! ㅠㅠ 이번 포스팅은 Glance와 Nova 설치편입니다. Glance 설치인스턴스를 생성하기 위해서는 운영체제가 설치되어 있는 이미지가 필요합니다. 이런 이미지 파일을 관리하는 서비스가 바로 Glance입니다. Glance는 오픈스택 컴퓨트 서비스를 사용하기 위한 주요 서비스에 해당합니다. 1. 우선 Openstack-glance와 python-glanceclient를 설치합니다. # yum install openstack-glance python-glanceclient 2. 설치가 완료되면 /etc/glance/glance-api.conf와 /etc/glance/glance-registry.conf 파일에 데이터베이스 정보를 다..

안녕하세요~!! 왜 이리도 바쁜지 블로그에 글을 올릴 시간이 없네요~!! 좋은 것이겠죠~!! ^^ 오늘은 안되겠다 생각이 들어서 이렇게 밤 늦게라도 시간을 내어서 글을 올려볼까 합니다. 오늘은 지난시간에 이어 Keystone 설치에 관련된 글을 올려볼까 합니다. yum install로 설치를 하고 vi가 아님 openstack-config를 이용하여 환경설정을 한다는 부분이 ubuntu의 apt-get install과 다른 부분입니다. 그외에 환경설정 내용이나 사용법은 같다고 보시면 됩니다. Keystone 설치메시지 서비스를 설치했다면 이번에는 Keystone을 설치할 차례입니다. Keystone은 오픈스택 서비스의 인증을 담당하는 서비스로써 테넌트, 사용자, 롤, 서비스와 endpoint를 관리합니다..

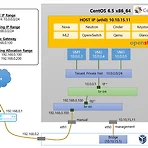

안녕하세요~!!지난시간에 이어 오늘은 CentOS6.5를 설치하고 거기에 컨트롤러 노드와 컴퓨트 노드를 설치해 보도록 하겠습니다.이번 시간에는 컨트롤러 노드의 기본 패키지들을 설치해 볼 예정입니다. 앞에서 Ubuntu에서 설치할 때와 같은 내용이 설치되며, 바뀌는 것이 있다면 OS와 설치명령어가 바뀔뿐입니다. 그럼, 지금부터 컨트롤러 노드를 설치해 볼까요~!! 컨트롤러 노드를 설치해 보자앞에서 우리는 오픈스택을 설치하기 위한 시스템 구성도를 그려보았습니다. 먼저 컨트롤러 노드에 데이터베이스, 메시지 서비스, 오픈스택 기본 서비스와 인스턴스의 가상 디스크를 관리하는 블록 스토리지 서비스를 설치하겠습니다. 네트워크 인터페이스 설정CentOS를 설치하면 네트워킹을 위한 IP를 설정해야 합니다. 우분투 서버와 ..

[OpenStack Class] 제44강 CentOS에서 설치해 보는 오픈스택 4편 - Multi node 설치

[OpenStack Class] 제44강 CentOS에서 설치해 보는 오픈스택 4편 - Multi node 설치

안녕하세요~!!지난시간까지는 서버 한대에 CentOS6.5를 설치하고 iceHouse 버전의 오픈스택을 PackStack을 이용하여 설치해 보고, Dashboard를 통하여 Neutron 네트워크 생성을 해 보았습니다. 오늘은 Multi node에서 오픈스택을 설치하기 위한 정말 필요한 기능만을 선택하여 오픈스택을 구성해 보도록 하겠습니다. Multi Node에서의 오픈스택 설치앞에서 노드 한대에 오픈스택을 모두 설치해 보았다면 이번에는 여러 노드에 오픈스택을 설치해 보도록 하겠습니다. 설치에 앞서 먼저 시스템 구성도를 그려보도록 하겠습니다. Multi Node에서 오픈스택 시스템 구성도Single Node에서는 PackStack을 이용해 Neutron 오픈스택을 설치하였다면 여기서는 기존 네트워크 방식..

[OpenStack Class] 제43강 CentOS에서 설치해 보는 오픈스택 3편 - All-in-One 설치

[OpenStack Class] 제43강 CentOS에서 설치해 보는 오픈스택 3편 - All-in-One 설치

안녕하세요~!!그동안 행사 준비 때문에 너무 바뻐서 강좌를 올릴 시간이 없었네요~!! 특히 그림이 많은 강좌는 더욱더 작업을 하기가 힘이 드는것 같습니다. 어여어여 모든 강좌를 다 오픈해 드려야 하는데 제가 너무 게을러서 이것도 너무 벅찬것 같습니다. 지난시간에는 Packstack All-in-One을 설치해 보았는데요~!! 이번 시간에는 OpenStack Dashboard에 접속해서 Neutron 네트워크를 추가해 보도록 하겠습니다. Dashboard 접속오픈스택 설치가 완료되었으면 데쉬보드에 접속해 보겠습니다. 1. 설치가 완료된 후 ls -al 명령을 입력하면 다음과 같이 keystone_admin이라는 파일을 확인할수 있습니다. $ ls –al total 44 -rw-------. 1 root r..

[OpenStack Class] 제42강 CentOS에서 설치해 보는 오픈스택 2편 - All-in-One 설치

[OpenStack Class] 제42강 CentOS에서 설치해 보는 오픈스택 2편 - All-in-One 설치

안녕하세요~!! 2015년을 맞이하여 처음으로 글을 써 봅니다. 블로그에 방문하시는 모든 분들이 올 한해도 하고자 하시는 모든 일이 다 잘 이루어 지길 바랍니다. 또한 새해 복도 많이 많이 받으셨으면 좋겠습니다. 오늘은 지난 포스팅에 이어 CentOS로 설치한 서버 한대에 오픈스택을 설치해 보도록 하겠습니다. Devstack으로도 CentOS에 오픈스택을 설치할 수 있지만, RedHat 계열인 CentOS는 RDO PackStack이라고 하는 아주 좋은 설치 툴이 있습니다. 그래서, 이번에는 PackStack을 이용하여 서버 한대에 오픈스택을 설치해 보도록 하겠습니다. All-in-One으로 오픈스택을 설치해 보자3장에서 우분투를 설치하고 데브스택을 이용해 오픈스택을 설치했다면 이번 장에서는 레드햇 계열..

- Total

- Today

- Yesterday

- 쿠버네티스

- Swift

- cpu

- 설치

- 하둡

- OVN

- 후기

- openstack

- ubuntu

- 오픈쉬프트

- Python

- 명령어

- 뉴트론

- install

- 오픈스택

- 클라우드

- sdn

- command

- NOVA

- 네트워크

- Redhat

- 컨테이너

- neutron

- 레드햇

- 파이썬

- Java

- 세미나

- 우분투

- Network

- 김미경

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |